专注Java教育14年

全国咨询/投诉热线:400-8080-105

更新时间:2021-06-15 15:39:41 来源:动力节点 浏览1477次

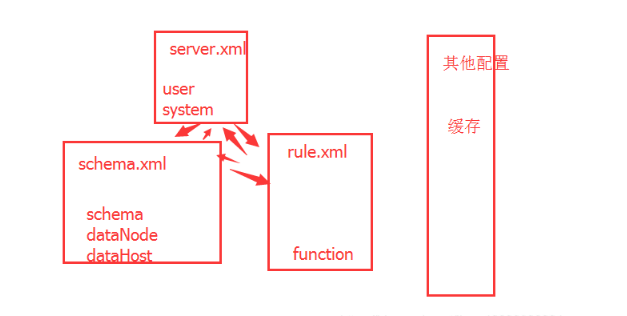

从这张图中就能知道,mycat的主要配置文件就三个:

server.xml

这个配置文件中:system中是配置的Mycat的服务器参数,user中配置的是用户、用户权限以及库信息。

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE mycat:server SYSTEM "server.dtd">

<mycat:server xmlns:mycat="http://io.mycat/">

<!--系统参数-->

<system>

<property name="nonePasswordLogin">0</property> <!-- 0为需要密码登陆、1为不需要密码登陆 ,默认为0,设置为1则需要指定默认账户-->

<property name="useHandshakeV10">1</property>

<property name="useSqlStat">0</property> <!-- 1为开启实时统计、0为关闭 -->

<property name="useGlobleTableCheck">0</property> <!-- 1为开启全加班一致性检测、0为关闭 -->

<property name="sequnceHandlerType">2</property>

<property name="subqueryRelationshipCheck">false</property> <!-- 子查询中存在关联查询的情况下,检查关联字段中是否有分片字段 .默认 false -->

<!-- <property name="useCompression">1</property>--> <!--1为开启mysql压缩协议-->

<!-- <property name="fakeMySQLVersion">5.6.20</property>--> <!--设置模拟的MySQL版本号-->

<!-- <property name="processorBufferChunk">40960</property> -->

<!--

<property name="processors">1</property>

<property name="processorExecutor">32</property>

-->

<!--默认为type 0: DirectByteBufferPool | type 1 ByteBufferArena | type 2 NettyBufferPool -->

<property name="processorBufferPoolType">0</property>

<!--默认是65535 64K 用于sql解析时最大文本长度 -->

<!--<property name="maxStringLiteralLength">65535</property>-->

<!--<property name="sequnceHandlerType">0</property>-->

<!--<property name="backSocketNoDelay">1</property>-->

<!--<property name="frontSocketNoDelay">1</property>-->

<!--<property name="processorExecutor">16</property>-->

<!--

<property name="serverPort">8066</property> <property name="managerPort">9066</property>

<property name="idleTimeout">300000</property> <property name="bindIp">0.0.0.0</property>

<property name="frontWriteQueueSize">4096</property> <property name="processors">32</property> -->

<!--分布式事务开关,0为不过滤分布式事务,1为过滤分布式事务(如果分布式事务内只涉及全局表,则不过滤),2为不过滤分布式事务,但是记录分布式事务日志-->

<property name="handleDistributedTransactions">0</property>

<!--

off heap for merge/order/group/limit 1开启 0关闭

-->

<property name="useOffHeapForMerge">0</property>

<!--

单位为m

-->

<property name="memoryPageSize">64k</property>

<!--

单位为k

-->

<property name="spillsFileBufferSize">1k</property>

<property name="useStreamOutput">0</property>

<!--

单位为m

-->

<property name="systemReserveMemorySize">384m</property>

<!--是否采用zookeeper协调切换 -->

<property name="useZKSwitch">false</property>

<!-- XA Recovery Log日志路径 -->

<!--<property name="XARecoveryLogBaseDir">./</property>-->

<!-- XA Recovery Log日志名称 -->

<!--<property name="XARecoveryLogBaseName">tmlog</property>-->

<!--如果为 true的话 严格遵守隔离级别,不会在仅仅只有select语句的时候在事务中切换连接-->

<property name="strictTxIsolation">false</property>

<property name="useZKSwitch">true</property>

</system>

<!-- 全局SQL防火墙设置 -->

<!--白名单可以使用通配符%或着*-->

<!--例如<host host="127.0.0.*" user="root"/>-->

<!--例如<host host="127.0.*" user="root"/>-->

<!--例如<host host="127.*" user="root"/>-->

<!--例如<host host="1*7.*" user="root"/>-->

<!--这些配置情况下对于127.0.0.1都能以root账户登录-->

<!--

<firewall>

<whitehost>

<host host="1*7.0.0.*" user="root"/>

</whitehost>

<blacklist check="false">

</blacklist>

</firewall>

-->

<!--用户管理-->

<user name="root" defaultAccount="true">

<property name="password">123456</property>

<!--在schema.xml中配置的虚拟库-->

<property name="schemas">TESTDB</property>

<!-- 表级 DML 权限设置 -->

<!--

<privileges check="false">

<schema name="TESTDB" dml="0110" >

<table name="tb01" dml="0000"></table>

<table name="tb02" dml="1111"></table>

</schema>

</privileges>

-->

</user>

<user name="user">

<property name="password">user</property>

<property name="schemas">TESTDB</property>

<!--该用户只有读权限-->

<property name="readOnly">true</property>

</user>

</mycat:server>

schema.xml

配置中主要包括:schema:虚拟数据库,dataNode:数据节点,dataHost:实际物理地址

<?xml version="1.0"?>

<!DOCTYPE mycat:schema SYSTEM "schema.dtd">

<mycat:schema xmlns:mycat="http://io.mycat/">

<!--一个schema代表一个虚拟库

name:虚拟的数据库

-->

<schema name="TESTDB" checkSQLschema="false" sqlMaxLimit="100">

<!--

table:实际的表,只是存储在多个物理节点上的数据库中

name:表名

primaryKey:主键

dataNode:存储的数据库节点

rule:分片规则,规则名字在rule.xml中定义。

type属性:定义逻辑表的类型,分为"全局表(global)"和"普通表"两种类型,不设置该值的时候默认普通表。

autoIncrement属性:使用该值的时候需要定义auto_increment,使用的时候最好配合数据库模式的全局序列。

-->

<!-- 表travelrecord根据id取模自动分发到dataNode中一个中 -->

<table name="travelrecord" dataNode="dn1,dn2,dn3" rule="auto-sharding-long" />

<!-- 表company做全局配置,即所有数据都在每个数据节点上存储。适用一些独立出来的小表-->

<table name="company" primaryKey="ID" type="global" dataNode="dn1,dn2,dn3" />

<!-- 使用mod共享规则进行随机分发,且主键自增由mycat控制 -->

<table name="hotnews" primaryKey="ID" autoIncrement="true" dataNode="dn1,dn2,dn3" rule="mod-long" />

<!-- 分片枚举 -->

<table name="employee" primaryKey="ID" dataNode="dn1,dn2" rule="sharding-by-intfile" />

<!-- 业务中有些表是有父子关系的或者一对多的关系,对应于父表的那条数据下的所有子表数据也分配到和父表相同的节点上。

当父表和子表都分配同一个分片上,就避免了跨库连接。

joinKey用于指定子表关联的字段;parentKey用于指定父表关联的字段;注意只有父表定义了分片规则rule子表是不定义的 -->

<table name="customer" primaryKey="ID" dataNode="dn1,dn2" rule="sharding-by-intfile">

<childTable name="orders" primaryKey="ID" joinKey="customer_id" parentKey="id">

<childTable name="order_items" joinKey="order_id" parentKey="id" />

</childTable>

<childTable name="customer_addr" primaryKey="ID" joinKey="customer_id" parentKey="id" />

</table>

<!--当数据节点较多时可以用这种形式表示-->

<table name="oc_call" primaryKey="ID" dataNode="dn1$0-743" rule="latest-month-calldate" />

</schema>

<!--

dataNode标签定义了mycat中的数据节点,这也就是我们通常所说的数据分片,一个单独的dataNode就是一个独立的数据分片

name属性:定义数据节点的唯一名字,上面schema中table的dataNode

dataHost:定义该分片所属的数据库实例,属性引用自dataHost标签上定义的name属性

database:定义该分片所属的数据库实例上的具体数据库。

-->

<!-- <dataNode name="dn1$0-743" dataHost="localhost1" database="db$0-743" /> -->

<dataNode name="dn1" dataHost="node1" database="db1" />

<dataNode name="dn2" dataHost="node2" database="db2" />

<dataNode name="dn3" dataHost="node2" database="db3" />

<!--

name:对应dateNade中的dataHost,唯一。

dbType:数据库类型 mysql\sequoiadb\oracle\mongodb\spark

maxCon:指定每个读写实例连接池的最大连接数。内嵌writeHost、readHost标签会使用这个属性的值来实例化连接池的最大连接数

minCon属性:指定每个读写实例连接池的最小连接数。初始化连接池的大小的属性。

balance属性:负债均衡类型,有四种

balance="0" : 不开启读写分离机制,所有的读操作都发送到当前可以用的writeHost上

balance="1" : 全部的readHost与stand by writeHost(双主从模式下的master) 都参与select语句的负债均衡

balance="2" : 所有的读操作都随机的往writeHost和readHost上分发

balance="3" : 所有的读分发到readHost上,writeHost负责写

writeType属性:负载均衡目前的取值有两种:

writeType="0":所有的写操作都发送到第一个writeHost,writeHost1挂了,则切换到writeHost2上,重新恢复writeHost1后,还是以writeHost2为准

writeType="1":所有的写操作都随机的发送到配置的writeHost上,1.5版本以后不推荐使用该值

dbDriver属性:制定后端数据库使用的Driver.目前可选的值为native和JDBC。

switchType属性:默认值为1,自动切换。

1表示不自动切换

2表示基于mysql主从同步的状态决定是否切换。

3表示基于mysql galaxy cluster 的切换机制

tempReadHostAvailable属性:如果配置了writeHost属性,下面的readHost依旧可以使用,默认为0

-->

<dataHost name="node1" maxCon="1000" minCon="10" balance="0" writeType="0" dbType="mysql" dbDriver="native" switchType="1" slaveThreshold="100">

<!--心跳测试-->

<heartbeat>select user()</heartbeat>

<!-- 写的实际数据库地址,这种就是配置读写分离 -->

<writeHost host="hostM1" url="localhost:3306" user="root" password="123456">

<!-- 也可以指定读的数据库地址 -->

<readHost host="hostS2" url="192.168.1.200:3306" user="root" password="xxx" />

</writeHost>

<!-- 也可以指定读的数据库地址,这种读写都在一个物理数据库中 -->

<writeHost host="hostS1" url="localhost:3316" user="root" password="123456" />

</dataHost>

<!--

<dataHost name="sequoiadb1" maxCon="1000" minCon="1" balance="0" dbType="sequoiadb" dbDriver="jdbc">

<heartbeat></heartbeat>

<writeHost host="hostM1" url="sequoiadb://1426587161.dbaas.sequoialab.net:11920/SAMPLE" user="jifeng" password="jifeng"></writeHost>

</dataHost>

<dataHost name="oracle1" maxCon="1000" minCon="1" balance="0" writeType="0" dbType="oracle" dbDriver="jdbc"> <heartbeat>select 1 from dual</heartbeat>

<connectionInitSql>alter session set nls_date_format='yyyy-mm-dd hh24:mi:ss'</connectionInitSql>

<writeHost host="hostM1" url="jdbc:oracle:thin:@127.0.0.1:1521:nange" user="base" password="123456" > </writeHost>

</dataHost>

<dataHost name="jdbchost" maxCon="1000" minCon="1" balance="0" writeType="0" dbType="mongodb" dbDriver="jdbc">

<heartbeat>select user()</heartbeat>

<writeHost host="hostM" url="mongodb://192.168.0.99/test" user="admin" password="123456" ></writeHost>

</dataHost>

<dataHost name="sparksql" maxCon="1000" minCon="1" balance="0" dbType="spark" dbDriver="jdbc">

<heartbeat> </heartbeat>

<writeHost host="hostM1" url="jdbc:hive2://feng01:10000" user="jifeng" password="jifeng"></writeHost>

</dataHost> -->

<!--<dataHost name="jdbchost" maxCon="1000" minCon="10" balance="0" dbType="mysql" dbDriver="jdbc">

<heartbeat>select user()</heartbeat>

<writeHost host="hostM1" url="jdbc:mysql://localhost:3306" user="root" password="123456"> </writeHost>

</dataHost> -->

</mycat:schema>

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE mycat:rule SYSTEM "rule.dtd">

<mycat:rule xmlns:mycat="http://io.mycat/">

<tableRule name="rule1">

<rule>

<columns>id</columns>

<algorithm>func1</algorithm>

</rule>

</tableRule>

<tableRule name="rule2">

<rule>

<columns>user_id</columns>

<algorithm>func1</algorithm>

</rule>

</tableRule>

<tableRule name="sharding-by-intfile">

<rule>

<columns>sharding_id</columns>

<algorithm>hash-int</algorithm>

</rule>

</tableRule>

<tableRule name="auto-sharding-long">

<rule>

<columns>id</columns>

<algorithm>rang-long</algorithm>

</rule>

</tableRule>

<tableRule name="mod-long">

<rule>

<columns>id</columns>

<algorithm>mod-long</algorithm>

</rule>

</tableRule>

<tableRule name="sharding-by-murmur">

<rule>

<columns>id</columns>

<algorithm>murmur</algorithm>

</rule>

</tableRule>

<tableRule name="crc32slot">

<rule>

<columns>id</columns>

<algorithm>crc32slot</algorithm>

</rule>

</tableRule>

<tableRule name="sharding-by-month">

<rule>

<columns>create_time</columns>

<algorithm>partbymonth</algorithm>

</rule>

</tableRule>

<tableRule name="latest-month-calldate">

<rule>

<columns>calldate</columns>

<algorithm>latestMonth</algorithm>

</rule>

</tableRule>

<tableRule name="auto-sharding-rang-mod">

<rule>

<columns>id</columns>

<algorithm>rang-mod</algorithm>

</rule>

</tableRule>

<tableRule name="jch">

<rule>

<columns>id</columns>

<algorithm>jump-consistent-hash</algorithm>

</rule>

</tableRule>

<function name="murmur"

class="io.mycat.route.function.PartitionByMurmurHash">

<property name="seed">0</property><!-- 默认是0 -->

<property name="count">2</property><!-- 要分片的数据库节点数量,必须指定,否则没法分片 -->

<property name="virtualBucketTimes">160</property><!-- 一个实际的数据库节点被映射为这么多虚拟节点,默认是160倍,也就是虚拟节点数是物理节点数的160倍 -->

<!-- <property name="weightMapFile">weightMapFile</property> 节点的权重,没有指定权重的节点默认是1。以properties文件的格式填写,以从0开始到count-1的整数值也就是节点索引为key,以节点权重值为值。所有权重值必须是正整数,否则以1代替 -->

<!-- <property name="bucketMapPath">/etc/mycat/bucketMapPath</property>

用于测试时观察各物理节点与虚拟节点的分布情况,如果指定了这个属性,会把虚拟节点的murmur hash值与物理节点的映射按行输出到这个文件,没有默认值,如果不指定,就不会输出任何东西 -->

</function>

<function name="crc32slot"

class="io.mycat.route.function.PartitionByCRC32PreSlot">

</function>

<function name="hash-int"

class="io.mycat.route.function.PartitionByFileMap">

<property name="mapFile">partition-hash-int.txt</property>

</function>

<function name="rang-long"

class="io.mycat.route.function.AutoPartitionByLong">

<property name="mapFile">autopartition-long.txt</property>

</function>

<function name="mod-long" class="io.mycat.route.function.PartitionByMod">

<!-- how many data nodes -->

<property name="count">3</property>

</function>

<function name="func1" class="io.mycat.route.function.PartitionByLong">

<property name="partitionCount">8</property>

<property name="partitionLength">128</property>

</function>

<function name="latestMonth"

class="io.mycat.route.function.LatestMonthPartion">

<property name="splitOneDay">24</property>

</function>

<function name="partbymonth"

class="io.mycat.route.function.PartitionByMonth">

<property name="dateFormat">yyyy-MM-dd</property>

<property name="sBeginDate">2015-01-01</property>

</function>

<function name="rang-mod" class="io.mycat.route.function.PartitionByRangeMod">

<property name="mapFile">partition-range-mod.txt</property>

</function>

<function name="jump-consistent-hash" class="io.mycat.route.function.PartitionByJumpConsistentHash">

<property name="totalBuckets">3</property>

</function>

</mycat:rule>

以上就是动力节点Java培训机构的小编针对“Mycat配置文件教学”的内容进行的回答,希望对大家有所帮助,如有疑问,请在线咨询,有专业老师随时为你服务。

Java实验班

Java实验班

0基础 0学费 15天面授

Java就业班

Java就业班

有基础 直达就业

Java夜校直播班

Java夜校直播班

业余时间 高薪转行

Java在职加薪班

Java在职加薪班

工作1~3年,加薪神器

Java架构师班

Java架构师班

工作3~5年,晋升架构

提交申请后,顾问老师会电话与您沟通安排学习